Je n’ai jamais vraiment pris le temps de faire un long guide détaillé sur l’audit technique d’un site web pour le seo. Il y a bien un guide seo sur le title et la meta description, un listing de ressources seo ou encore bien d’autres conseils mais pas de guide sur l’audit technique. Bonne lecture !

Je n’ai jamais vraiment pris le temps de faire un long guide détaillé sur l’audit technique d’un site web pour le seo. Il y a bien un guide seo sur le title et la meta description, un listing de ressources seo ou encore bien d’autres conseils mais pas de guide sur l’audit technique. Bonne lecture !

- Domaine

- Serveur

- Robots.txt

- Sitemap et localisation

- Outil d’analyses statistiques

- Hyperliens

- Qualité du code source

- Contenus

- Indexation

1) Nom de domaine

Première chose à faire, s’assurer que le domaine sur lesquels vous allez faire vivre votre site soit le votre, et encore pour longtemps. Un petit coup de Whois vous permettra d’avoir réponse à cette question (registar, date de création, expiration, serveurs du domaines).

Ensuite, allez jeter un œil pour voir si le domaine apparaît dans les résultats Google, au moins sur son nom. Si ce n’est pas le cas, il va falloir procéder à un ensemble de vérification qui sont dans énoncées plus loin dans ce post. Vous pouvez aussi jeter un œil à Waybackmachine, pour voir à quoi ressemblait le site par le passé… On ne sait jamais, peut-être que sa précédente forme était “anti bonnes pratiques seo” !

2) Serveur

La vitesse d’un site d’une manière générale est un critère de ranking, aussi bien pour la partie naturelle que pour l’Adwords. Reste que ce critère est d’une importance disons… Mesurée !

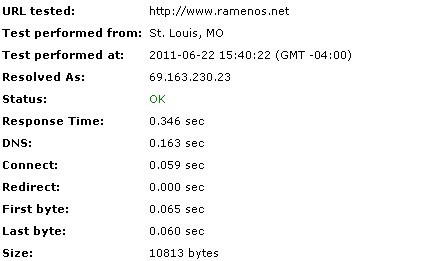

Le temps de réponse du serveur est la première chose à vérifier. Si la réponse arrive en moins d’une seconde, c’est bon. N’oubliez jamais de choisir au préalable un hébergeur située dans le pays ciblé par votre site web, ça ne sera que positif pour les dits utilisateurs. Aidez-vous d’un outil comme Pingdom ou Website Pulse pour le calculer.

Ensuite, vérifier l’état de votre page 404. Pour cela, installez-vous un petit service comme le très pratique HTTPfox pour Firefox. Tapez le nom d’une page inexistante dans votre barre d’adresse et regardez ce qui s’affiche. Une page d’erreur 404 doit apparaître et elle doit aussi renvoyer un code d’erreur 404.

Rediriger les racines miroirs du domaine : il arrive que les sites créés possèdent des adresses miroirs d’entrées. D’un point de vue SEO, il est important de rediriger ces miroirs vers l’unique URL d’entrée afin d’éviter la duplication de contenus et faciliter le crawl du moteur. Quant à l’utilisateur, il n’aura qu’un seul et bon choix, y compris pour faire des liens. Quelques exemples de miroirs bien connus :

- http://www.monsite.com/

- http://www.monsite.com

- http://www.monsite.com/index.php

- http://monsite.com

- http://monsite.com/

3) Le fichier robots.txt

Le fichier robots.txt doit se trouver à la racine du site et y contenir les règles d’interdiction de crawl pour les moteurs de recherche. Voici les différents points à appliquer systématiquement :

- Placer le fichier robots.txt à la racine du site pour que son accès soit le suivant : http://www.monsite.com/robots.txt

- Interdire l’accès des pages inutiles à tous les robots.

- Interdire les robots qui ne servent à rien et qui ralentissent le serveur.

- Ralentir les robots qui envoient beaucoup trop de requêtes (c’est souvent le cas avec Yahoo, à ce moment-là il faut appliquer un Crawl-delay).

- (Optionnel) Déclarer l’adresse de votre fichier sitemap.

4) Sitemap et géolocalisation

En inscrivant votre site à Google Webmaster Tools, vous pouvez très rapidement spécifier certains détails pour le référencement de votre site web.

Tout d’abord, vous pouvez envoyer votre Sitemap à Google. L’opération prend 5 secondes montre en main, il faut juste déclarer l’URL d’accès de votre sitemap dans la partie “Configuration du site”: il peut s’agit d’un sitemap web ou vidéo. Profitez-en pour regarder si votre fichier robots.txt est accessible et contient bien les bonnes règles.

Dans la partie “Paramètres”, choisissez le pays cible de vos potentiels utilisateurs. Je n’ai jamais vu de grandes différences, que la case soit cochée ou non mais ça ajoute un petit + pour la recherche locale.

5) Outil d’analyses statistiques

Bête mais indispensable, assurez-vous que les tags relatifs à votre outil d’analyse (Google Analytics, Xiti, Omniture, Webtrends…) soient bien placés sur toutes les pages de votre site et qu’ils fonctionnent.

Par contre, évitez d’avoir une multitude d’outils pour le même site. D’abord parce que ça va ralentir le chargement de vos pages d’avoir plein de scripts de partout, mais aussi parce que vous n’arriverez pas à vous faire une idée de votre trafic réel si vous jonglez entre plusieurs outils… Tenez-vous en à une solution, ça sera plus simple. Petit point pour Google Analytics, si vous décidez de l’implanter, pensez à bien installer la dernière version du tag asynchrone qui affiche des statistiques relatives au temps de chargement des pages :).

Et si vous avez une multitude de tags installés qui correspondent à plusieurs outils du même type, profitez-en pour faire un peu de ménage… J’en connais encore certains qui ont toujours leur tag Xiti gratuit sur leur site alors que l’ensemble est analysé par Google Analytics depuis fort longtemps :p.

6) Hyperliens

Les liens, il y en a partout et il est très important d’instaurer des règles et vérification selon leur type.

- Liens cassés : les liens cassés sont ceux qui amènent votre utilisateur sur une page 404, ce qui génère une frustration au niveau de l’expérience. Pour détecter facilement quels sont les liens cassés de votre site, utilisez un bon vieux Xenu. Gratuit, ce petit programme fait toujours des merveilles pour le métier seo.

- Liens sortants : il s’agit des liens qui vont pointer vers un domaine différent, ou alors un sous-domaine. Google a depuis bien longtemps considéré les sous-domaines comme des domaines à part. De ce fait, je ne vous recommande pas d’en avoir énormément par page, de peur de perdre facilement vos visiteurs. Bien sur, il y a facilement des exceptions pour lesquels leur présence sera plus que justifiée (sous-domaine du site, blog du site, forum, autres sites du réseau, jeux concours…).

- Liens vendus : il s’agit généralement de liens externes qui pointent vers des sites web qui n’ont aucun rapport avec le votre. Google désapprouve la vente/achat de liens depuis longtemps mais pour ceux qui en font, ajouter un attribut rel=”nofollow” sur les liens sortant va vous permettre de vous prémunir contre une quelconque pénalisation. Reste bien sur plusieurs façons de déjouer ce système…

- Liens internes : il s’agit des liens pointant vers les pages du même site. Assurez-vous qu’il n’existe qu’une seule version de l’URL pour chaque page du site. Même si les redirections miroirs sont mises en place, avoir de la duplication interne n’est vraiment pas très propre. Le format du lien interne doit être le suivant :

<a href=”http://www.monsite.fr/ma-page/”>Ma page</a>

- Liens à éviter : flash, avec redirections, javascript ou encore les liens avec l’attribut rel=”nofollow” si ce dernier n’est pas justifié.

- Ration liens/contenus : qu’il s’agisse de liens sortant, vendus ou internes, assurez-vous de ne pas avoir une page envahie de liens, surtout si la masse de vos contenus est assez faible. En effet, un grand nombre de liens par page aura tendance à diluer davantage les performances seo acquises sur chacune de vos pages. Google recommande généralement de ne pas dépasser 100 liens/page. Cependant, cette information est vieille et l’algorithme a bien évolué depuis. De mon point de vue, je reste dubitatif à l’idée d’avoir une page d’accueil ou de niveau 1 qui contient plus de 150 liens.

7) Qualité du code source

Balises title et meta remplies correctement : base éditoriale du seo, le title est l’élément éditorial le plus important. Assurez-vous qu’il soit différent sur toutes les pages du site et que les 60 premiers caractères soient dédiés aux variables changeantes. Cette règle s’applique également à la balise meta description qui doit être correctement remplie (environ 160 caractères) et différentes sur chaque page du site. Si elle n’influe pas dans l’algorithme global de Google, elle a une incidence sur le taux de clics. Toute autre balise meta est strictement inutile d’un point de vue seo (hormis la meta robots).

- Gestion du CSS : plus le code sera propre, concis et bien structuré, plus il sera facile pour Google de crawler rapidement l’intégralité d’une page. Externalisez votre style CSS dans un fichier à part.

- Javascript : même remarque pour la feuille de style CSS. Il peut y en avoir quelques uns s’ils occupent 2-3 petites lignes de code mais si vous commencez à avoir des fonctions gigantesques qui polluent la lisibilité de la page, préférez externaliser.

- Encodage des caractères : très important à prendre en compte, surtout pour l’affichage du title et meta description.

- Validité W3C : pour rappel, le fait d’avoir un site valide W3C n’influe en rien votre positionnement. Par contre, vous serez conformes aux règles du web et c’est toujours bon à prendre.

- HTML 5 : depuis la version 5, plusieurs normes ont fait leur apparition, comme notamment le renommage des zones principales d’une page web. Cependant, j’attire votre attention sur le fait que la gestion des balise <h1>, <h2> a changé. Auparavant, Google préconisait toujours un seul <h1> par page. Avec HTML 5, le discours de Matt Cutts a légèrement évolué :). Globalement, avoir plus d’un h1 par page n’est pas grave, s’il y a une logique structurelle derrière. De mon côté, j’ai bien vu plusieurs exemples de sites qui ont plusieurs h1 par page et qui sont très bien positionnés (notamment celui-ci). Cependant, je pense qu’il est toujours préférable d’avoir le premier <h1> de la page qui change pour chaque URL.

8) Contenus de vos pages

Le contenu, techniquement parlant, doit être organisé de manière logique d’un point de vue HTML et SEO.

- Comme dit plus haut, le title doit être unique et définir rapidement le contenu de votre page. Ce title doit bien sur être différent sur chaque page de votre site.

- La meta description suit la même règle.

- Les balises h1, h2, h3, etc doivent être hiérarchisés de manière cohérente afin de structurer correctement la page d’un point de vue éditorial.

- La duplication de contenus est bien entendu à proscrire et Google est beaucoup plus sévère depuis Panda. De plus ça n’a pas de sens d’un point de vue utilisateur. Si néanmoins vous devez avoir une duplication d’une partie de vos pages au sein de votre site ou sur un domaine externe, mettez en place une règle de canonical URL, permettant à Google de déterminer l’URL préférée et connaître la source du contenu.

- Le contenu caché est également à proscrire sous toutes ses formes possible (indentation, couleur, transparent, display none et j’en passe). L’utilisateur ne doit pas voir le contenu affiché ? Mettez un accès par mot de passe ou n’affichez pas le contenu.

- Les pop-up : vintage à l’origine, vintage encore aujourd’hui, avoir du contenu éditorial dans une pop-up (ou une iframe) n’est pas recommandé ni d’un point de vue seo, ni d’un point de vue utilisateur.

9) Les images

- Taille des images : il est important de conserver une taille raisonnable lors de l’insertion d’images sur son site web. Vous pouvez prendre le temps d’optimiser l’image pour qu’elle ait un poids moindre mais si vous n’avez pas envie de perdre trop de temps, utiliser un service tel que Webresizer sera mieux que rien.

- Favicon : c’est toujours un petit + pour la notoriété du site et il apparaît parfois dans les résultats de certains moteurs de recherche.

- Image logo vers la racine : j’ai entendu de tout à propos de la gestion de l’image logo. Entre mettre un H1 dessus, écrire du texte caché derrière cette image, il vaut mieux rester simple et propre. Intégrez cette image via la commande HTML normale et ajouter un descriptif dans la balise ALT et title).

Pour en savoir plus sur la gestion des images pour le seo, je vous invite à lire mon post sur l’optimisation des images pour le seo.

10) URL et indexation

Comme je l’ai dit en haut de ce post, vous pouvez agir sur la qualité d’indexation de vos pages à travers le fichier robots.txt. Même si vous interdisez l’accès de pages aux moteurs de recherche, ces derniers les trouvent et les indexent quand même mais en fond d’index, elles ne ressortent jamais dans les résultats habituels.

- La balise meta robots permet, comme le fichier, d’interdire l’indexation d’une page mais on peut également autoriser/refuser le suivi du contenu de cette page.

<meta name=”robots” content=”noindex, nofollow”>

- De votre côté, vous pouvez connaître le nombre de pages indexées par Google en tapant la commande “site:monsite.com” (sans les guillemets). Cette commande est bien pratique car elle permet de savoir si l’indexation de vos pages s’est faite correctement, section par section. Plus d’infos sur l’utilisation de site ici.

- Le niveau de profondeur est également un critère à prendre en compte. Plus une page est à un niveau de profondeur élevé, moins la fréquence de crawl sera élevée. Bien entendu, pour pallier à ce problème, vous aurez pris soin d’élaborer une structure d’information optimale, pour l’utilisateur, comme pour les moteurs. A vous d’établir plusieurs chemins d’entrées vers vos pages importantes… Sans pour autant avoir 300 liens/page ! :)

Voilà, c’est à peu près tout pour le moment. J’ai peut-être oublié un point ou deux, mais n’hésitez pas à commenter/compléter ce petit guide.

Merci beaucoup pour ce best-of, clair et complet.

Je me posais la question depuis un moment pour l’histoire des racines miroirs du domaine.

Petite question : c’est bien avec une redirection 301 que l’on va régler le problème ?

Par exemple, si l’on veut privilégier http://www.monsite.com, il faut mettre, dans le .htacess :

RedirectPermanent http://www.monsite.com/ http://www.monsite.com

RedirectPermanent http://www.monsite.com/index.php http://www.monsite.com

RedirectPermanent http://monsite.com http://www.monsite.com

RedirectPermanent http://monsite.com/ http://www.monsite.com

Et seconde question : je n’arrive pas à trouver le lien entre l’article et l’image de Wall-E … Y a t-il un sens caché ?

@Thomas : oui, c’est bien du redirect 301 à mettre en place.

Pour ta 2ème question, c’est juste un délire perso avec Wall-E et la bidouille électronique. Mais je vais peut-être mettre Burn-E à la place… Ça colle mieux ! :)

Super billet, merci !

J’ai tout de même une petite question :

“Interdire les robots qui ne servent à rien et qui ralentissent le serveur.”

Comme par exemple ?

Merci pour la confirmation !

Pour Wall-E pas de soucis, le truc c’est qu’à chaque fois ça me donne envie de le revoir ^_^

Je propose également d’évoquer la nouvelle norme des microdatas données par schema.org

Je rajouterais qu’il est important de vérifier que le site n’utilise pas de techniques de spam (cloacking, etc..) qui auraient pu être mises en place par le webmaster ou un référenceur précédent. Ce serait dommage que le site se fasse sanctionner en retard :D

Cela a le mérite d’être simple et c’est un audit qui s’attache à des questions de 1ère importance.

Pour la question du texte sous le logo, je préfère pour le moment le laisser dans une balise h1 et l’indenter. Jusqu’à ce jour, cela me paraît fonctionner correctement.

Tiens pour une fois c’est une liste qui change de ce qu’on peut voir sur le reste du web, c’est bien et c’est complet

Un très excellent post.Bravo

Je t’invite à regarder tes logs de serveur et tu vas vite savoir qui consomme beaucoup de bande passante sur ton site. Il y a bien souvent des robots inutiles.

Il m’est déja arrivé de voir qu’un institut crawlait l’un de mes sites clients juste pour tester quelque chose pour un de leur projet… Cool mais ça faisait tomber le serveur de temps en temps =)

Bonjour, comment dois-je procéder pour rediriger mes racines miroirs du domaine ?

Très bon article, j’ai particulièrement aimé les deux liens pour tester la vitesse de réponse du serveur.

J’avais une remarque concernant ton point sur le contenu caché. S’il est certes interdit de cacher du contenu, il existe tout de même des techniques qui ne sont pas contraires à mon sens à cette règle. Je pense à une partie de contenu qui serait masqué en javascript, que l’internaute pourrait afficher en cliquant sur un lien “lire la suite”. Les moteurs pourront le lire et les internautes aussi s’ils le souhaitent.

Excellent billet, très détaillé. Merci pour toutes ces infos ;)

Yes liste d’audit bien utile !!! merci.

Petit outils gratuit à rajouter à ta liste pour vite vérifier les meta title en double et autres : XENU

Et UN.CO.VER pour le duplicate :)

Ouch !! Website Pulse n’est pas tendre avec mon site ! Pas mal de boulot en perspective. Merci ceci dit pour cette check list bien utile pour le novice que je suis.

Cela fait un petit moment que j’avais mis cet article de côté pour le lire avec attention et il le mérite. Je rejoins le Juge quand il dit qu’il est rare de trouver un guide aussi complet pour au audit SEO.

Je rajouterai cependant 2 chapitres: un sur le cloaking et autres formes de nuisibles mais ça déjà été évoqué et aussi un chapitre à proprement parlé sur les URL. Ton chapitre 10 semble l’évoquer dans le titre mais le contenu concerne plutôt l’indexation.

J’entends par URL, le fait d’être dynamique, statique, SEO Friendly,etc.

En tout cas très bon initiative de partager des ressources rares.

Excellent article, pleins d’outils et de techniques intéressantes pour auditer son site. Je l’ajoute dans mes bookmarks.

Website pulse est particulièrement utile.

Les outils de Greg sont également importants : cela permet d’éviter le duplicate content dans les meta titles.

Bel article, il reprend bien les bases de ce que doit comprendre un audit seo technique …

Comme outil tu parles de XENU, il est bien mais j’ai une petite préférence pour screaming frog … et pour la mesure de performances gtmetrix est pas mal …

Super, merci !

Que peut-on déduire de l’ordre des résultats d’une commande site:monsite.com ?

merci pour l’article et p’être pour la réponse ;-)

Tu peux aussi vérifier qu’il n’y a pas que le sous domaine www/ sans www qui est indexé, j’en ai parlé dans un article ici http://www.nicemedia.fr/blog/articles-referencement/trouvez-desindexez-facilement-les-domaines-100-dupliques-de-votre-site ça te permet de trouver tout les sous domaines, domaines, ip, etc, qui sont indexés avec le site en duplicate. Ca arrive bien plus souvent qu’on ne le pense !